Oggi vi vogliamo parlare di un interessante esperimento fatto da un ricercatore, Gabriel Goh, il quale ha riunito all’interno di una sua rete neurale due programmi: una sorta di generatore di immagini come Deep Dream – realizzato dal MIT – e un open source di Yahoo, che si preoccupa di individuare – e quindi di censurare – eventuali immagini di natura pornografica.

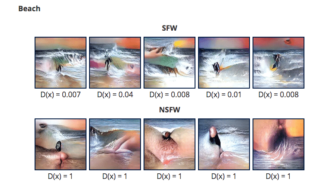

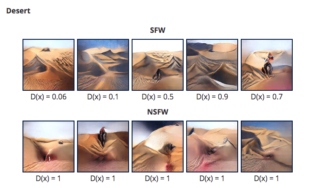

Unendo le due differenti forme di intelligenza artificiale, il ricercatore è riuscito a creare un programma che è in grado di generare – casualmente – delle immagini contraddistinte da una certa impronta NSFW (Not Suitable/Safe For Work, ossia non appropriato): la rete neurale si è preoccupata di assegnare i valori 0 e 1, il primo per le immagini senza connotazione NSFW e, il secondo, per individuare invece immagini con un’impronta porno.

L’esperimento mostra risultati interessanti quando la rete neurale arriva a creare immagini NSFW basate su scenari già elaborati dall’AI del MIT: in effetti, paesaggi con spiagge, concerti o canyon, vengono identificati come materiali potenzialmente NSFW, a causa delle sagome riprodotte e soprattutto dei colori, giacché vengono scambiate per organi genitali umani.

Ecco forse spiegato come mai, in alcuni casi, immagini chiaramente innocue divengano invece – almeno per l’AI – dei manifesti alla volgarità e alla pornografia: dato uno sguardo alle foto qui di seguito per farvi un’idea al riguardo…